不是 Z-Image-Base,而是Z-Image-Omni-Base

不是 Z-Image-Base,而是Z-Image-Omni-Base

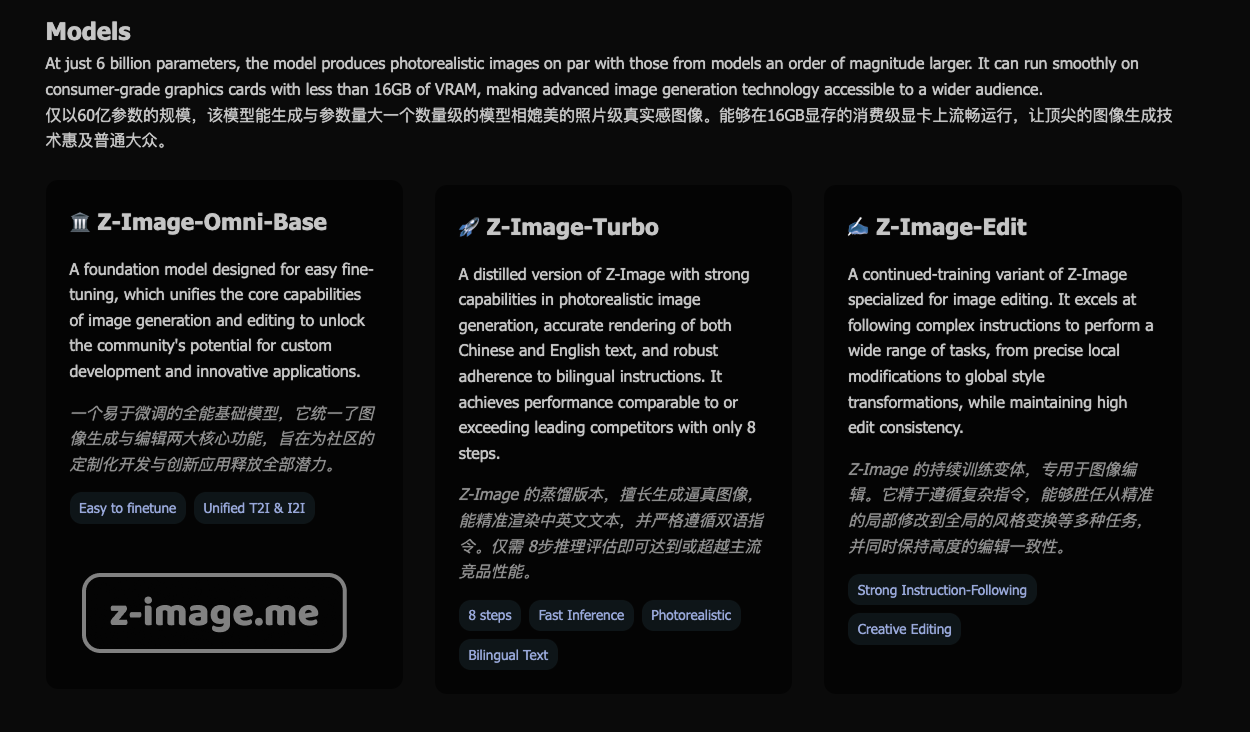

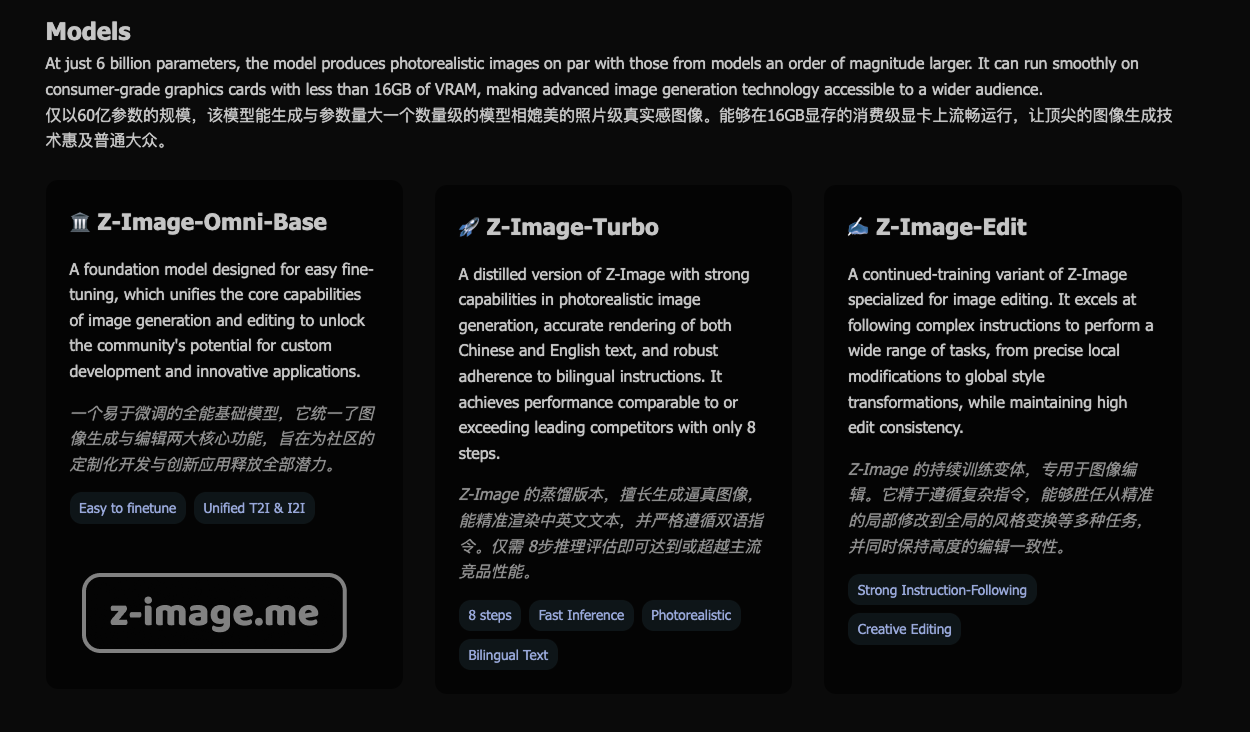

在AI图像生成技术的迅猛演进中,阿里巴巴的Tongyi-MAI团队推出的Z-Image系列模型以其高效的6B参数规模和照片级真实感脱颖而出。然而,作者最近观察到在Z-Image的官网 Z-Image-blog中,原先的Z-Image-Base已悄然更名为Z-Image-Omni-Base (ModelScope和Hugging Face截止发稿前还没有修改)。这一名称修改并非简单的标签调整,而是象征着模型架构向“omni”(全能)预训练的战略转变:它强调了统一处理图像生成和编辑任务的能力,避免了传统模型在任务切换时的复杂性和性能损失。通过整合生成与编辑数据的omni预训练管道,这一转变意味着Z-Image-Omni-Base在参数效率上更进一步,支持无缝的多模态应用,如LoRA适配器的跨任务使用,从而为开发者提供更灵活的开源工具,减少了需要多个专用变体的需求。

Z-Image系列的兴起:从基础到Omni的演进

Z-Image系列的核心架构是Scalable Single-Stream Diffusion Transformer (S3-DiT),所有变体均采用统一的输入流设计,将文本、视觉语义令牌和图像VAE令牌串联处理。这使得模型在多语言(中英)文本渲染和指令遵循方面表现出色。根据最新技术报告(arXiv:2511.22699,2025年12月1日发布),omni预训练是关键创新,它统一了生成和编辑流程,避免了双流架构的冗余。社区讨论中,这一omni特性促使用户将基础版称为Z-Image-Omni-Base,突出其全能性,而非单纯的生成基础模型。

最新动态显示,Z-Image-Turbo已于2025年11月26日发布,权重开源于Hugging Face和ModelScope,并提供在线演示空间。相比之下,Z-Image-Omni-Base和Z-Image-Edit的权重仍处于“即将发布”状态(GitHub仓库无11月后更新),社区预计这一延迟与进一步优化omni功能相关。用户反馈(如Reddit讨论)赞赏Turbo的亚秒级推理速度(H800 GPU上,支持8步推理和CFG=1),但也指出Omni-Base的统一能力在复杂任务中更具优势,例如生成多样化图像(如成分驱动的菜肴或数学图表)并支持自然语言编辑,而无需模型切换。

版本对比:Omni-Base的独特定位

为厘清名称修改的含义,我们对比系列变体。所有模型共享6B参数和单流架构,但Omni-Base的omni预训练使其在生成/编辑间无缝过渡,这一点在社区中被视为从“Base”到“Omni-Base”的本质转变:它不仅提升了通用性,还允许LoRA等微调在统一框架下应用,避免了如Qwen-Image中生成与编辑的分离训练。

| 特性/方面 | Z-Image-Turbo (蒸馏版) | Z-Image-Omni-Base (基础Omni版) | Z-Image-Edit (编辑版) |

|---|---|---|---|

| 主要能力 | 快速生成、多语言渲染;亚秒级速度。 | 统一生成/编辑;高多样性和真实感,支持omni LoRA。 | 精确编辑、强指令遵循。 |

| 速度与需求 | 最快,消费级GPU (<16GB VRAM)支持。 | 较慢,但灵活性高;需>20步推理。 | 中等,专注编辑效率。 |

| 基准性能 | 开源SOTA,在Alibaba AI Arena领先。 | 质量优于Turbo,但未发布基准;omni训练提升通用性。 | 编辑精度突出,避免漂移。 |

| 优势 | 适合快速迭代;社区工具集成广。 | Omni预训练无缝任务切换;替代Qwen-Image的统一方案。 | 创意重绘,尊重约束。 |

| 劣势 | 编辑需自定义工作流;细节偶有不足。 | 图像可能“AI泛化”风格;nudity等特殊功能不确定。 | 生成不如Omni多样。 |

| 适用场景 | 概念艺术、新闻可视化。 | 自定义开发、跨任务微调。 | 图像修改、精确调整。 |

从表格可见,Omni-Base的定位在于其全能性:社区用户指出,它可运行于RTX 3090等硬件,支持Q8_0量化,并在如nudity生成等边缘功能上提供潜力(虽Turbo已支持,但Omni版需LoRA解锁)。与更大模型如Qwen-Image(20B)相比,Z-Image系列更高效,但Omni-Base通过Decoupled-DMD和DMDR算法在细节和高频渲染上竞争力强。

研发与未来:Omni预训练的潜力

Z-Image系列由阿里巴巴Tongyi-MAI团队研发,焦点在于参数效率和蒸馏技术。Omni预训练的引入标志着从分任务模型向统一框架的转变,这一名称修改(社区中已流行)预示着未来开源生态的趋势:更少的变体分裂,更强的任务兼容性。目前,Turbo全面可用,而Omni-Base和Edit开发完成,权重发布延迟可能与优化相关。社区贡献活跃,包括stable-diffusion.cpp集成(支持4GB VRAM)和对视频扩展的推测,虽官方未确认。